BC/NW 2024 № 1 (41):15.2

ИСПОЛЬЗОВАНИЕ МОДИФИКАЦИИ FINE-TUNING

НА ПРЕДОБУЧЕННОЙ МОДЕЛИ GPT

Наумов Н.А., Оцоков Ш.А.

В последние годы трансформерные модели, такие как GPT (Generative Pre-trained Transformer), привлекли широкое внимание исследователей и разработчиков в области обработки естественного языка. На сегодняшний день одним из актуальных направлений исследований является применение модификации Fine-Tuning на предобученных моделях, таких как GPT, для решения конкретных задач в области NLP и генерации текста[1].

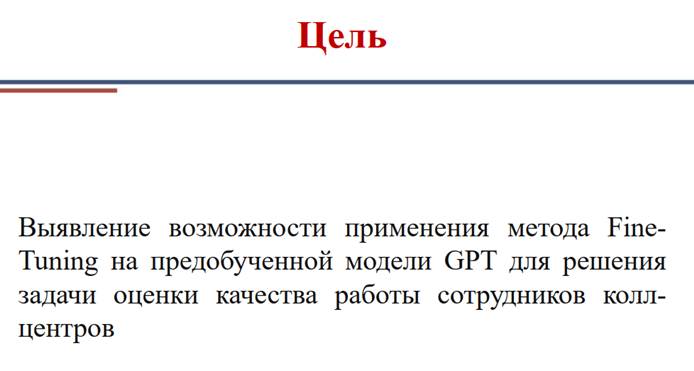

Эта тема имеет высокую актуальность в свете постоянного развития методов глубокого обучения и искусственного интеллекта. Цель данного исследования заключается в оценке эффективности и потенциала применения метода Fine-Tuning на предобученной модели GPT для решения различных практических задач.

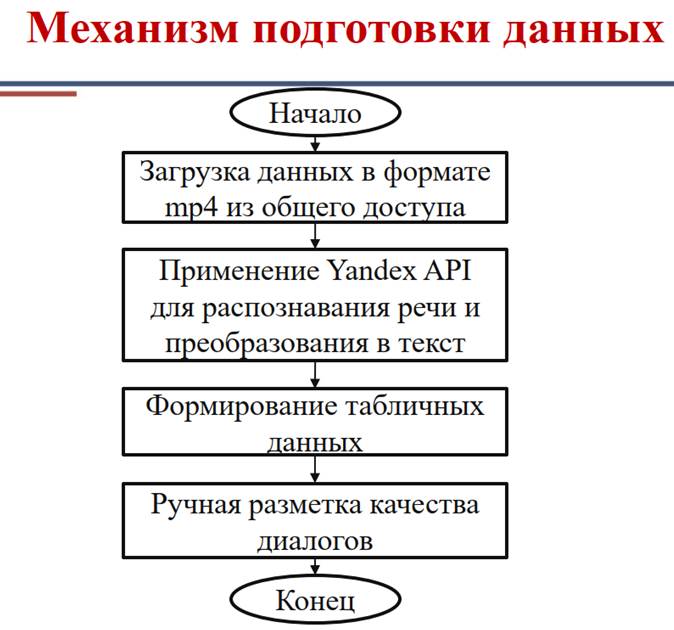

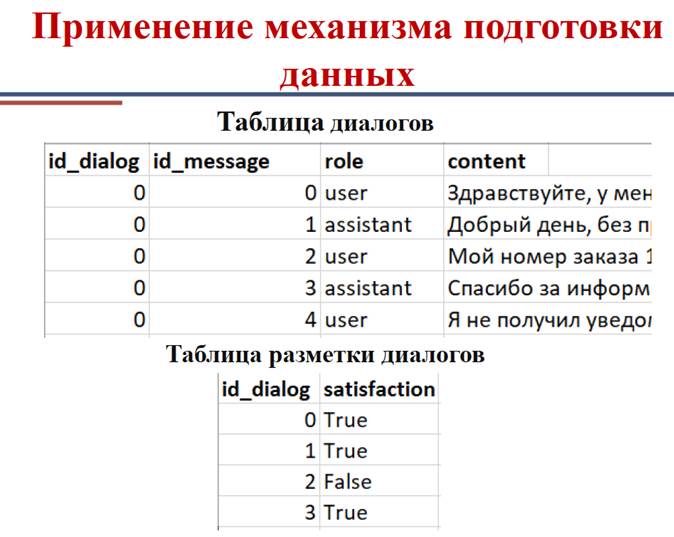

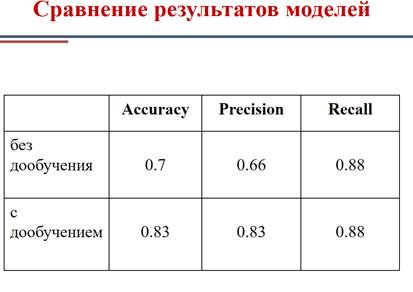

Для достижения описанной цели в данной работе разработана программа для формирования и предобработки данных, пригодных для дообучения модели GPT, включая сегментацию, очистку и преобразование в формат, пригодный для входа конкретной модели. Также проведено дообучение модели GPT на полученных данных с целью адаптации модели к конкретной задаче. Наконец оцениваются результаты выполнения конкретной задачи моделью GPT без предварительной обработки данных в сравнении с результатами, полученными после дообучения, для определения улучшений в качестве решения конкретной задачи.

Литература

1. Marcos Treviso, Ji-Ung Lee, Tianchu Ji, Betty van Aken, Qingqing Cao / Efficient Methods for Natural Language Processing: A Survey // Transactions of the Association for Computational Linguistics (2023) 11: 826–860.